Di balik performa sebuah server yang terasa cepat dan responsif, ada satu elemen teknis yang sering diabaikan yaitu pengaturan TCP/IP Tuning Server. Banyak admin hanya mengandalkan konfigurasi bawaan sistem operasi, padahal sedikit penyesuaian pada parameter jaringan bisa mengubah throughput secara signifikan. Bagi layanan dengan trafik tinggi seperti aplikasi finansial, e commerce, hingga layanan streaming, tuning ini bukan lagi opsi tambahan melainkan kebutuhan.

Mengapa TCP/IP Tuning Server Menentukan Kinerja Jaringan

TCP/IP Tuning Server pada dasarnya adalah proses mengoptimalkan parameter protokol jaringan agar sesuai dengan karakteristik beban kerja dan infrastruktur. Protokol bawaan dirancang generik agar aman dan stabil di berbagai skenario, tetapi bukan selalu yang tercepat. Di sinilah tuning berperan, menyesuaikan antara kapasitas jaringan, kemampuan hardware, dan pola trafik aplikasi.

Banyak masalah yang sering dianggap sebagai “server lambat” sebenarnya bersumber pada konfigurasi TCP/IP yang konservatif. Contohnya koneksi yang cepat penuh, latency yang tidak wajar, hingga throughput yang mentok di angka tertentu walau bandwidth masih longgar. Dengan memahami cara kerja TCP, admin bisa mengidentifikasi bottleneck dan mengatasinya lewat parameter yang tepat, bukan sekadar menambah resource server.

> “Sering kali penambahan CPU dan RAM hanya menutupi masalah, bukan menyelesaikan akar persoalan throughput jaringan.”

Fondasi Teknis TCP/IP Tuning Server di Sistem Modern

Sebelum menyentuh parameter yang lebih spesifik, penting memahami fondasi teknis yang menjadi dasar TCP/IP Tuning Server. Tanpa pemahaman dasar ini, perubahan konfigurasi berisiko membuat koneksi tidak stabil atau justru menurunkan performa.

Konsep Window dan Buffer dalam TCP/IP Tuning Server

Salah satu konsep terpenting dalam TCP/IP Tuning Server adalah ukuran window dan buffer. TCP menggunakan mekanisme sliding window untuk mengontrol berapa banyak data yang boleh dikirim sebelum menunggu konfirmasi dari penerima. Semakin besar window, semakin banyak data yang dapat mengalir sekaligus, yang berpengaruh langsung pada throughput terutama di jaringan berlatensi tinggi.

Buffer send dan receive di sisi kernel menentukan seberapa besar data yang bisa ditampung. Jika terlalu kecil, koneksi akan cepat “penuh” dan aplikasi seperti database, web server, atau reverse proxy akan mengalami antrian internal. Namun jika terlalu besar tanpa perhitungan, bisa menghabiskan memori dan menimbulkan efek samping lain seperti latency yang meningkat.

Latency, Bandwidth, dan BDP pada TCP/IP Tuning Server

Bandwidth Delay Product atau BDP adalah metrik penting dalam TCP/IP Tuning Server. BDP diperoleh dari perkalian bandwidth dengan latency. Nilai ini menggambarkan berapa banyak data yang “menggantung” di jaringan pada satu waktu. Jika buffer dan window size lebih kecil dari BDP, throughput tidak akan pernah menyentuh kapasitas maksimal link.

Sebagai contoh, koneksi 1 Gbps dengan latency 50 ms membutuhkan buffer yang jauh lebih besar dibanding koneksi 100 Mbps dengan latency 5 ms. Tanpa penyesuaian, server hanya akan memanfaatkan sebagian kecil dari bandwidth yang tersedia, meski secara teori jaringan mampu menyalurkan jauh lebih banyak data.

Parameter Kunci TCP/IP Tuning Server di Linux

Linux menjadi sistem operasi yang paling sering dipakai untuk server, sehingga pemahaman tentang parameter TCP/IP Tuning Server di lingkungan ini sangat krusial. Kernel Linux menyediakan banyak opsi melalui sysctl yang bisa diatur sesuai kebutuhan.

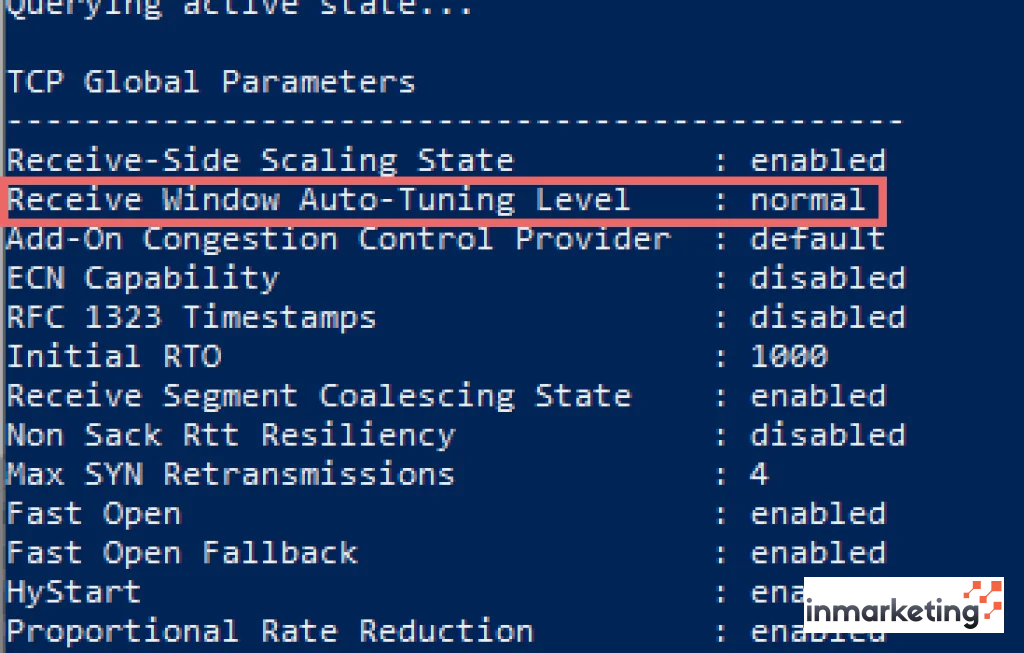

Pengaturan Buffer dan Window pada TCP/IP Tuning Server

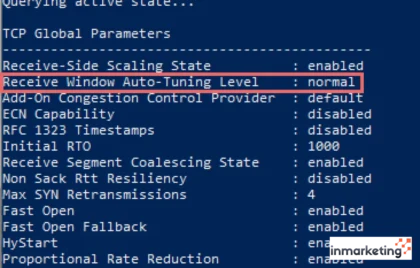

Untuk meningkatkan throughput, admin biasanya memulai dari pengaturan buffer. Parameter seperti net.core.rmem_max, net.core.wmem_max, net.ipv4.tcp_rmem, dan net.ipv4.tcp_wmem menjadi titik awal utama dalam TCP/IP Tuning Server.

Dengan menaikkan nilai maksimum dan rentang nilai default buffer ini, server dapat menangani koneksi yang lebih berat dan transfer data yang lebih besar. Namun, setiap perubahan perlu diuji dengan beban nyata karena efeknya bisa berbeda antara aplikasi streaming, API, atau file transfer. Pendekatan yang seragam untuk semua jenis server sering kali tidak optimal.

TCP Congestion Control sebagai Faktor Penentu

Selain buffer, algoritma congestion control adalah elemen penting dalam TCP/IP Tuning Server. Linux mendukung beberapa algoritma seperti cubic, bbr, dan yang lain. Masing masing memiliki karakteristik berbeda dalam menghadapi kemacetan jaringan.

Cubic sering menjadi default karena stabil dan adaptif, tetapi untuk skenario tertentu seperti koneksi berlatensi tinggi dan bandwidth besar, BBR dapat memberikan peningkatan throughput yang signifikan. Pemilihan algoritma ini memerlukan pengujian karena tidak semua jaringan dan perangkat di jalur koneksi bereaksi sama terhadap perubahan pola pengiriman paket.

Optimasi TCP/IP Tuning Server untuk Server Web dan API

Server web dan API memiliki karakteristik trafik yang unik yaitu banyak koneksi pendek dan sering menggunakan protokol di atas HTTP. TCP/IP Tuning Server di lingkungan ini tidak hanya soal throughput mentah, tetapi juga efisiensi dalam menangani ribuan koneksi simultan.

Koneksi Pendek dan Pengaruhnya pada TCP/IP Tuning Server

Pada server web, banyak koneksi yang hanya berlangsung sepersekian detik untuk melayani satu permintaan. Di sini, parameter seperti tcp_fin_timeout, tcp_tw_reuse, dan tcp_tw_recycle dulu sering diutak atik, meski beberapa sudah tidak direkomendasikan lagi di kernel modern. Tujuan utamanya mengurangi penumpukan koneksi dalam state TIME_WAIT dan mempercepat pelepasan resource.

Dalam konteks TCP/IP Tuning Server, admin perlu menyeimbangkan antara agresivitas pembersihan koneksi lama dan stabilitas koneksi baru. Pengaturan yang terlalu agresif dapat menyebabkan masalah intermiten yang sulit dilacak, misalnya sebagian kecil permintaan gagal tanpa pola yang jelas.

Keepalive, Reuse Port, dan Skala Koneksi

Pengaturan keepalive juga berperan dalam TCP/IP Tuning Server. Interval dan jumlah percobaan keepalive menentukan seberapa lama koneksi idle dipertahankan. Untuk layanan API yang sering dipanggil berulang oleh klien yang sama, menjaga koneksi tetap hidup bisa mengurangi overhead handshake TCP dan TLS.

Selain itu, beberapa server modern memanfaatkan SO_REUSEPORT untuk mendistribusikan beban ke banyak worker. Di sisi kernel, kombinasi pengaturan ini dengan backlog yang cukup besar akan membuat server lebih tahan terhadap lonjakan trafik mendadak. Tanpa tuning, lonjakan semacam ini sering memicu peningkatan latency dan error koneksi walau resource CPU dan memori masih aman.

Strategi TCP/IP Tuning Server pada Lingkungan Cloud

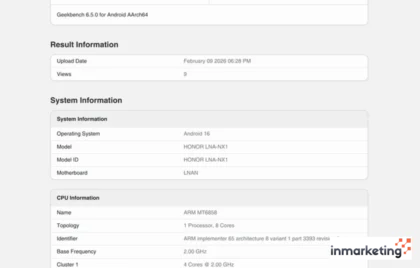

Pindah ke cloud tidak otomatis membuat urusan TCP/IP Tuning Server menjadi tidak relevan. Justru di lingkungan virtualisasi dan container, tuning menjadi lebih rumit karena ada lapisan abstraksi tambahan seperti virtual NIC, load balancer, dan overlay network.

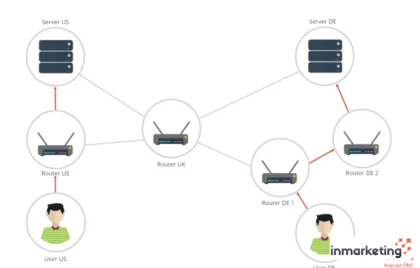

Interaksi TCP/IP Tuning Server dengan Load Balancer

Banyak arsitektur cloud menggunakan load balancer di depan server aplikasi. Di sini, TCP/IP Tuning Server perlu mempertimbangkan dua sisi yaitu antara klien ke load balancer dan antara load balancer ke server backend. Karakteristik koneksi di kedua sisi bisa berbeda, misalnya satu koneksi klien dipertahankan lama sementara ke backend dibuat koneksi baru.

Parameter seperti idle timeout pada load balancer harus selaras dengan pengaturan keepalive di server. Jika tidak, koneksi bisa sering terputus mendadak dan klien merasakan jeda tambahan karena harus membuat koneksi baru. Tuning yang tepat akan mengurangi overhead ini dan memaksimalkan throughput end to end.

Container, Namespace, dan Batasan Kernel

Di lingkungan container, sebagian pengaturan TCP/IP Tuning Server masih berada di level host, bukan di dalam container. Ini sering menimbulkan kebingungan karena admin mengubah konfigurasi di container tetapi efeknya tidak signifikan. Memahami batas mana yang diatur per namespace dan mana yang global menjadi penting.

Selain itu, pembatasan resource seperti cgroup juga mempengaruhi perilaku TCP. Misalnya, jika memori dibatasi ketat, peningkatan buffer yang agresif bisa berujung pada thrashing atau OOM di container. TCP/IP Tuning Server di lingkungan ini harus lebih konservatif dan sangat bergantung pada observasi metrik runtime.

> “Tuning jaringan di cloud bukan sekadar menyalin konfigurasi bare metal, tetapi menyesuaikan dengan lapisan virtual yang menambah kompleksitas baru.”

Uji Coba, Monitoring, dan Iterasi pada TCP/IP Tuning Server

Satu kesalahan umum dalam TCP/IP Tuning Server adalah menganggap konfigurasi tertentu sebagai “resep sakti” yang berlaku universal. Setiap perubahan parameter harus diiringi pengujian terukur dan pemantauan jangka waktu tertentu sebelum dianggap berhasil.

Pengujian throughput menggunakan alat seperti iperf, pengukuran latency, serta observasi metrik kernel seperti jumlah koneksi aktif, retransmission, dan packet drop menjadi bagian wajib dari proses ini. Tanpa data, tuning hanya menjadi eksperimen acak yang kebetulan kadang terasa lebih cepat di satu sisi tetapi menimbulkan masalah baru di sisi lain.

Pendekatan iteratif membuat admin dapat merapikan konfigurasi sedikit demi sedikit, menghindari perubahan drastis yang sulit di rollback. Dengan dokumentasi yang baik, setiap tim bisa memahami alasan di balik setiap parameter TCP/IP Tuning Server yang diterapkan, bukan hanya menyalin dari contoh konfigurasi yang tersebar di internet.

Comment